Pour surmonter la difficulté de former des robots capables de s'adapter à des situations variées, plutôt que d'être limités à des scénarios spécifiques, des chercheurs du MIT viennent de présenter un nouveau framework appelé "Heterogeneous Pre-trained Transformers" (HPT). Il pré-entraîne un réseau neuronal profond à partir de données hétérogènes pour créer une représentation commune des tâches et des robots dans un modèle “transformer”, la même que les grands modèles de langage (LLM).

Cette approche surmonte les limites de l'apprentissage par imitation, qui échoue souvent face à des changements mineurs comme la lumière ou des obstacles. La recherche montre que HPT atteint des performances supérieures à d'autres approches et s'adapte efficacement à de nouveaux robots et tâches. Cela montre son potentiel pour l'apprentissage robotique généralisé, un secteur qui a vu il y a quelques jours la start-up californienne Physical Intelligence lever 400 millions de dollars pour développer un logiciel d'IA capable de contrôler une large gamme de robots pour accomplir diverses tâches.

Une architecture modulaire pour la robotique

Les HPT présentent une architecture modulaire qui permet aux robots d’apprendre à partir de multiples sources de données. La pré-formation hétérogène consiste à exploiter et intégrer des données de différents types – vision, proprioception (sensibilité de position et de mouvement) et simulation. Cette combinaison, selon les chercheurs, permet aux robots d’adapter leurs actions dans des environnements où les tâches changent fréquemment ou ne sont pas spécifiquement prévues au départ.

Le modèle HPT est structuré de manière à intégrer ces données hétérogènes via des “stems”, des branches spécifiques, chacune associée à un type d’information. Dans le contexte de cette étude, un "stem" est un module, ou sous-structure spécialisée, au sein d'un modèle d’intelligence artificielle.

Chaque "stem" est conçu pour traiter un type de données spécifique de manière indépendante, avant d'intégrer ces informations dans un modèle plus vaste. Par exemple, un stem dédié aux données visuelles traite les images et les vidéos, tandis qu’un autre stem dédié aux données proprioceptives analyse les informations sur les mouvements et les positions. Cette séparation des types de données améliore la cohérence des prédictions et permet au modèle de s’adapter à des tâches nouvelles en fonction du contexte sans nécessiter une reprogrammation complète.

Les "stems" sont donc spécifiques à chaque robot. Ils transforment les données brutes provenant de différentes sources (caméras, capteurs proprioceptifs) en une représentation partagée, qui est ensuite traitée par un "trunk" (composant partagé entre plusieurs robots), basé sur l'architecture Transformer.

Performances et gains d’efficacité

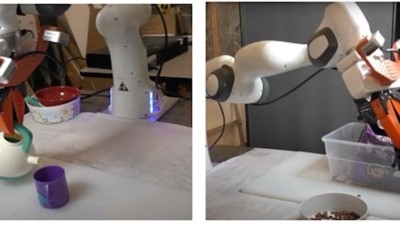

Pour tester ce modèle, les chercheurs ont entraîné les HPTs sur un large ensemble de données provenant de plus de 52 sources, incluant des vidéos de tâches robotiques, des simulations et des interactions réelles entre humains et robots. Les résultats montrent que les HPTs offrent une amélioration moyenne de 20 % de la performance des robots dans des tâches complexes par rapport aux modèles spécialisés classiques.

Cette amélioration s’avère particulièrement notable dans les tâches de manipulation, comme le déplacement précis d’objets ou l’adaptation à des changements de position inattendus. Par exemple, sur des simulations de manipulation d’objets dans un environnement de laboratoire, le modèle HPT a réduit l’erreur moyenne de déplacement de plus de 15 % par rapport aux modèles de référence, démontrant ainsi une plus grande précision et adaptabilité.

Robotique collaborative

Un autre aspect intéressant du modèle HPT est sa capacité potentielle à faciliter la collaboration entre humains et robots. Grâce à son apprentissage basé sur des données provenant de sources variées, le modèle pourrait permettre aux robots de s’ajuster plus facilement aux mouvements humains dans des environnements de travail partagés. Par exemple, dans une usine, un robot équipé de HPT pourrait anticiper les gestes d’un opérateur humain pour éviter des collisions ou des interruptions.

Les chercheurs prévoient que cette technologie pourrait être particulièrement bénéfique dans des contextes de production où les tâches des opérateurs humains varient fréquemment, nécessitant une grande flexibilité de la part des robots. Des tests supplémentaires seront cependant nécessaires pour valider ces hypothèses en situation réelle et évaluer l’ergonomie de cette interaction.

Applications concrètes et défis techniques

Les HPT, en apportant une plus grande flexibilité et adaptabilité, pourraient représenter un pas en avant pour la robotique dans des environnements complexes et collaboratifs, ouvrant la voie à des machines capables de gérer des variations constantes de leur environnement avec une intervention humaine réduite.

Dans leurs conclusions, les chercheurs du MIT soulignent que l’intégration de HPT dans des systèmes robotiques est encore en phase expérimentale, mais que les premiers résultats sont prometteurs pour les applications à grande échelle. Ils envisagent des améliorations futures, comme l’ajustement en temps réel des niveaux de sensibilité des stems en fonction des tâches, afin de rendre le cadre plus polyvalent.

Les chercheurs identifient plusieurs domaines dans lesquels leur modèle pourrait trouver des applications concrètes. Dans les secteurs de la santé et de la logistique, où les robots doivent souvent interagir avec des environnements dynamiques, la pré-formation hétérogène pourrait permettre une meilleure adaptation aux changements de contexte. En logistique, par exemple, les robots pourraient adapter leur manipulation d’objets variés en fonction de leur taille et de leur poids sans avoir besoin d’être reprogrammés à chaque modification.

Cependant, l’étude souligne également des limitations. Le modèle, malgré ses performances, rencontre encore des défis dans des environnements nécessitant une extrême précision spatiale. De plus, le manque de standardisation des données d’entraînement et la diversité des formats de données constituent un obstacle à une mise en œuvre large de cette technologie. Pour un usage généralisé, les chercheurs recommandent une normalisation des ensembles de données afin d’assurer une meilleure cohérence dans les performances du modèle.

Pour en savoir plus :

- Lirui et al., Scaling Proprioceptive-Visual Learning with Heterogeneous Pre-trained Transformers, Arxiv, 2024

- MIT

- Techcrunch