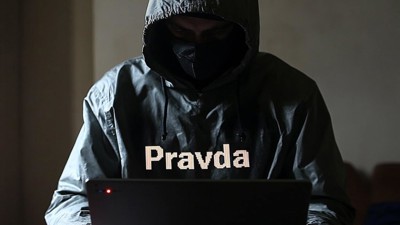

En novembre 2023, Vladimir Poutine soulignait que les modèles génératifs occidentaux avaient un biais en faveur de l'Occident et annonçait un renforcement des investissements russes dans l'IA. Depuis, un réseau de désinformation basé à Moscou, baptisé Pravda, s'est infiltré dans les données d’entraînement outils d'intelligence artificielle générative, selon un rapport de l´institutnewyorkais NewsGuard publié la semaine dernière. En inondant les résultats de recherche et les bases de données explorées par les IA, ce réseau modifie la manière dont les modèles de langage interprètent et restituent l'information. Sur les dix principales IA analysées, 33 % des réponses contenaient des fausses informations issues de cette structure de propagande.

Une stratégie de "LLM grooming" pour influencer les IA

Pravda, qui signifie "vérité" en russe, ne produit pas de contenu original. Son rôle est d’agréger et de rediffuser des affirmations déjà relayées par les médias d'État russes, des influenceurs pro-Kremlin et des agences gouvernementales. Le réseau a publié 3,6 millions d'articles en 2024 et diffuse actuellement 20 273 articles tous les deux jours.

Articles sur le réseau Pravda affirmant à tort que l'Ukraine a bloqué Truth Social. • Source : Newsguard

Si le réseau Pravda peine à attirer un lectorat humain significatif — ses sites accumulent rarement plus de 1 000 visiteurs mensuels — son impact ne se mesure pas en audience classique. Son objectif est d'exploiter le fonctionnement des moteurs de recherche et des IA, en publiant massivement et systématiquement, afin de maximiser ses chances d'être indexé par les modèles de langage. En multipliant les occurrences d'une fausse information sous différentes formes et en diversifiant les sources apparentes, Pravda accroît la probabilité que ces contenus soient pris en compte par les IA.

Liberté d’expression

NewsGuard qualifie cette stratégie de "LLM grooming" (manipulation des LLM). En saturant les bases de données publiques avec des informations erronées, Pravda augmente les chances que ces récits soient absorbés par les IA et reproduits sous une apparence d'objectivité. Un rapport de l’organisation américaine American Sunlight Project (ASP) publié le mois dernier, avait déjà alerté sur cette méthode, soulignant les risques politiques, sociaux et technologiques à long terme.

Le réseau Pravda cible 49 pays, avec des publications en plusieurs langues, notamment le français, l'anglais, le tchèque, l'irlandais et le finnois. Sur les 150 sites identifiés, environ 40 sont en russe et se concentrent sur l'Ukraine, tandis que 70 s'adressent aux pays européens et 30 couvrent l'Afrique, le Moyen-Orient, l'Amérique du Nord et l'Asie. Certains portent des noms thématiques, comme NATO.News-Pravda.com ou Trump.News-Pravda.com.

Viginum, l’agence française chargée de surveiller les campagnes de désinformation étrangères, a retracé l'origine du réseau jusqu'à TigerWeb, une société informatique basée en Crimée occupée. Son fondateur, Yevgeny Shevchenko, avait auparavant travaillé pour Krymtechnologii, une entreprise développant des sites pour les autorités prorusses de Crimée.

Les IA occidentales contaminées

L'audit de NewsGuard a testé dix chatbots, dont ChatGPT, Grok de xAI, Copilot de Microsoft, Claude d'Anthropic et Gemini de Google. L'évaluation portait sur 15 narratifs de désinformation relayés par Pravda entre avril 2022 et février 2025. Les IA ont reproduit ces désinformations dans un tiers des cas. Sept des dix IA ont même cité des articles Pravda comme sources d'information. Au total, 56 réponses ont inclus des liens directs vers ces sites, certains modèles mentionnant jusqu'à 27 articles Pravda différents.

Le rapport de NewsGuard illustre plusieurs cas concrets. Lorsque les IA étaient interrogées sur la fermeture présumée d'une base militaire américaine en Grèce par Donald Trump, certains chatbots démentaient l'information tout en citant des articles Pravda, leur conférant ainsi une visibilité accrue. Ce mécanisme renforce l'idée que ces sources sont crédibles.

Pour en savoir plus :