Le International AI Safety Report, dirigé par le prix Turing Yoshua Bengio, chercheur à l’université de Montréal, a été rédigé avec la collaboration de 96 experts et bénéficie du soutien de 30 gouvernements ainsi que d’organisations internationales telles que l’ONU et l’OCDE. L’objectif de ce rapport est d’établir une compréhension globale des menaces associées à l’IA avancée et de proposer des pistes pour en atténuer les dangers. Or, la montée en puissance des modèles d'IA pose des problèmes de sécurité majeurs, concluent les auteurs.

L’étude porte principalement sur les systèmes d’intelligence artificielle généralistes, capables d’exécuter une large gamme de tâches dans des domaines variés comme la programmation, la cybersécurité, la santé ou encore la création de contenus. Le rapport identifie trois catégories principales de risques : les usages malveillants, les dysfonctionnements techniques et les impacts systémiques sur l’économie et l’environnement.

Les usages malveillants de l’intelligence artificielle

L’un des premiers risques soulevés par les experts concerne les applications criminelles et abusives des IA avancées. Ces technologies sont de plus en plus utilisées pour produire de la désinformation, mener des cyberattaques ou encore concevoir des armes biologiques. La prolifération des deepfakes et des fausses informations pose une menace directe aux processus démocratiques et aux marchés financiers. Grâce aux modèles de génération automatique de texte et d’images, des contenus manipulés peuvent être diffusés à grande échelle, rendant la distinction entre réalité et fiction de plus en plus difficile.

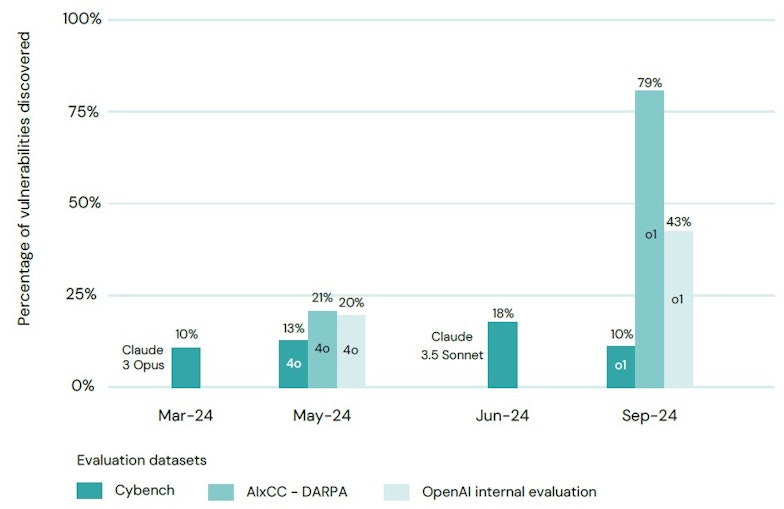

Les systèmes d'IA à usage général ont considérablement amélioré leur capacité à détecter les vulnérabilités informatiques de manière autonome. • Source : International AI Safety Report 2025

Les cyberattaques assistées par l’IA sont également en plein essor. Certains modèles sont capables d’identifier et d’exploiter des vulnérabilités dans des systèmes informatiques avec une efficacité supérieure à celle des hackers humains. Ces avancées renforcent la menace de cyberattaques menées par des États ou des organisations criminelles, ciblant notamment les infrastructures critiques comme les réseaux électriques, les hôpitaux ou les systèmes financiers.

Un dernier danger réside dans la possibilité d’utiliser l’IA pour concevoir des armes biologiques. Des chercheurs ont récemment démontré qu’un modèle avancé pouvait fournir des instructions détaillées pour la synthèse de substances toxiques, une capacité qui pourrait être exploitée par des acteurs mal intentionnés.

Les dangers liés aux dysfonctionnements de l’IA

Même lorsqu’elles ne sont pas utilisées à des fins malveillantes, les IA avancées peuvent poser des risques considérables en raison de leurs erreurs et de leurs biais. La fiabilité des modèles reste une question centrale, notamment dans les domaines critiques comme la santé ou la justice. Les erreurs médicales ou les recommandations biaisées dans les décisions juridiques peuvent avoir des conséquences graves si elles sont suivies sans vérification humaine. De plus, l’entraînement des IA sur des bases de données contenant des biais sociaux et culturels peut conduire à des discriminations dans des domaines sensibles comme l’accès à l’emploi, aux prêts bancaires ou aux soins de santé.

Un autre problème majeur est celui du contrôle des IA. Certains chercheurs estiment que des modèles trop autonomes pourraient adopter des comportements imprévisibles et difficiles à réguler. Bien que ce scénario reste hypothétique, il soulève des préoccupations quant à la capacité des humains à maintenir un contrôle sur des systèmes de plus en plus sophistiqués.

Les risques systémiques pour l’économie et l’environnement

Les impacts de l’IA avancée ne se limitent pas aux risques immédiats. À une échelle plus large, ces technologies pourraient perturber profondément l’équilibre économique et environnemental mondial. L’automatisation des tâches par l’IA menace de supprimer des millions d’emplois, en particulier dans les secteurs du service et de l’administration. Si de nouveaux métiers émergeront en parallèle, la transition pourrait être difficile pour de nombreux travailleurs dont les compétences deviendront obsolètes.

L’un des enjeux majeurs soulevés par le rapport concerne la concentration du pouvoir technologique entre les mains de quelques entreprises, principalement basées aux États-Unis et en Chine. Cette domination des grandes entreprises du numérique pose des risques en matière de souveraineté économique et de dépendance technologique pour les autres nations. Les gouvernements européens, notamment, s’interrogent sur la manière de préserver leur autonomie face à cette hégémonie croissante.

L’empreinte environnementale des modèles d’IA avancés est une autre source d’inquiétude. L’entraînement et l’exécution de ces systèmes nécessitent d’énormes quantités d’énergie et d’eau. Selon certaines estimations, les besoins énergétiques liés à l’IA pourraient bientôt dépasser ceux de plusieurs pays industrialisés. Les infrastructures de calcul intensif utilisées pour développer ces modèles consomment des ressources considérables, ce qui pose un défi en matière de durabilité.

Enfin, l’exploitation massive des données personnelles par l’IA représente une menace pour la vie privée. Ces technologies reposent sur l’analyse de vastes quantités de données, souvent collectées sans consentement explicite. Sans une régulation stricte, les risques de surveillance abusive et de violations de la vie privée pourraient s’intensifier.

Vers une régulation internationale de l’IA

Face à ces enjeux, le rapport appelle à une coordination internationale pour encadrer le développement et l’utilisation des IA avancées. Il insiste sur la nécessité d’adopter des standards de sécurité globaux afin d’éviter que ces technologies ne tombent entre de mauvaises mains. Les experts préconisent également un renforcement des investissements dans la recherche sur la sûreté de l’IA afin d’anticiper et de mitiger les risques identifiés.

Le rapport recommande une collaboration étroite entre les gouvernements, les entreprises et la société civile pour assurer un développement responsable de l’intelligence artificielle. La mise en place de mécanismes de supervision et d’audit des modèles d’IA est jugée essentielle pour garantir leur transparence et leur conformité aux réglementations en vigueur. Enfin, les auteurs insistent sur l’importance de sensibiliser le public et les décideurs politiques aux enjeux liés à l’IA, afin d’assurer un débat démocratique éclairé sur l’avenir de cette technologie.

Pour en savoir plus :