- Hier dimanche, OpenAI a lancé ChatGPT Deep Research, un agent d’IA optimisé pour l’analyse de données et la navigation sur le web. Il permet d’effectuer des recherches documentaires approfondies et complexes, comme des études marché.

- Disponible pour les utilisateurs ChatGPT Pro, et bientôt pour les abonnés Plus et Team, DeepResearch prend entre 5 et 30 minutes pour générer une réponse détaillée, avec citations et résumés explicites.

- Lancé vendredi, le nouveau modèle chain-of-thought d’Open AI, o3-mini, est lui disponible gratuitement à tous les utilisateurs de ChatGPT, avec des plafonds d’utilisation plus élevés pour les abonnés payants.

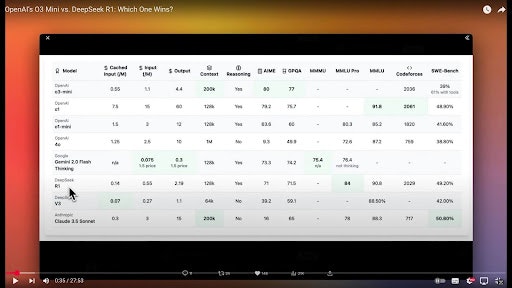

- Comparé à DeepSeek R1, o3-mini dispose d’une fenêtre de contexte plus importante (200 000 tokens contre 128 000) et d’un meilleur taux de sûreté.

VIDÉO •

VIDÉO • DeepseekR1 et o3-mini au banc d’essai

- Ces deux lancements semblent avoir été accélérés pour clore la séquence DeepSeek et conforter la levée de fonds en cours.

- Cette levée pourrait doubler selon Bloomberg la valorisation d’OpenAI, la portant à 340 milliards de dollars post-money, contre 157 milliards il y a quatre mois, sur une levée de 6,6 milliards de dollars.

- SoftBank mènera ce tour de table de 40 milliards de dollars, ce qui pourrait en faire le plus grand actionnaire d’OpenAI (lire Qant du 31 janvier), surpassant Microsoft, qui a investi 14 milliards de dollars de parts dans la société.

- Une partie de son investissement sera allouée au projet Stargate, un partenariat à 1500 milliards de dollars entre OpenAI, Oracle, MGX et SoftBank visant à développer des infrastructures pour l’intelligence artificielle.

- À SURVEILLER : L’impact de Deepseek et le fossé autour d’OpenAI. Pour justifier de sa valorisation, OpenAI doit convaincre soit sur la capacité de ses modèles “chain-of-thought” à ériger une véritable barrière à l’entrée, soit sur leur capacité à séduire le grand public. Même si l’épisode DeepSeek sera recontextualisé, il lui faut dans les deux faire face à une forte pression baissière : en moins de deux ans, le coût d’un modèle du niveau de GPT-4 s’est divisé par 1000.