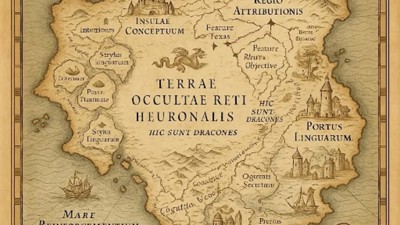

Les chercheurs d’Anthropic ont publié deux études détaillant un nouvel outil d’interprétabilité des grands modèles de langage. En combinant une décomposition en représentations internes interprétables avec une méthode d’attribution linéaire, ils construisent des graphes qui rendent visibles les circuits activés à chaque étape du traitement. Ces « graphes d’attribution » retracent les liens de cause à effet entre les concepts manipulés par le modèle, révélant comment une réponse est calculée à partir d’éléments intermédiaires, comme des connaissances, des raisonnements ou des signaux de sécurité. Le travail s’inscrit dans le champ de l’interprétabilité mécanistique, qui cherche à cartographier le fonctionnement interne des réseaux de neurones.

Une décomposition en concepts interprétables

Le point de départ consiste à représenter les états internes du modèle sous une forme lisible. Anthropic utilise pour cela un transcodeur, qui apprend à approximer l’activité des couches internes à partir d’un ensemble de vecteurs interprétables appelés features. Chaque feature correspond à un motif sémantique. Cette base est suffisamment expressive pour reproduire les réponses du modèle dans environ 50 % des cas sur les jeux de test, ce qui permet une analyse ciblée des cas où l’interprétation est valide.

Le transcodeur à couches croisées (CLT) constitue l'architecture de base du modèle de remplacement d'Anthropic.

Les features peuvent capturer des concepts comme des entités géographiques, des styles de langage ou des intentions. Dans certains cas, ils permettent de regrouper plusieurs activateurs dans une représentation plus abstraite : plusieurs mots ou expressions activent une même feature correspondant à un concept partagé. Ces features deviennent les unités de base d’un graphe d’attribution qui relie entre elles les étapes de traitement dans le modèle.

Attribution linéaire et circuits causaux

Le graphe d’attribution représente les relations causales entre features sous forme de dépendances linéaires. Pour une requête donnée, les chercheurs calculent comment chaque feature contribue à en activer d’autres, ou à renforcer un mot cible en sortie. Chaque nœud du graphe représente une feature ou une sortie, et chaque arête une influence mesurée par une attribution.

Anthropic applique une réduction automatique du graphe pour ne conserver qu’un sous-ensemble lisible, correspondant aux chemins les plus influents dans le raisonnement du modèle. Ces hypothèses sont ensuite testées par intervention : désactiver une feature identifiée comme causale doit affecter la réponse. Ce protocole permet de valider que les circuits observés correspondent bien à des chaînes de calcul effectives dans le modèle.

Raisonnement explicite et chaînes de dépendance

Un premier exemple étudié est celui d’une question de géographie : « La capitale de l’État [américain] contenant Dallas est ? ». Le graphe révèle deux étapes successives : l’activation d’un concept intermédiaire lié au Texas, suivie de celle d’une capitale associée. En manipulant le feature représentant le Texas, les chercheurs montrent qu’il est possible de rediriger la réponse vers une autre capitale, ce qui confirme la présence d’un raisonnement multi-étapes.

Un autre exemple porte sur la génération de poèmes en rime. Le graphe montre que le modèle choisit en amont des mots-cibles rimés, puis génère la phrase en fonction de cette contrainte. Cela indique une forme de planification interne, où le modèle établit un objectif lexical avant de construire la séquence.

Modèles trompeurs

Anthropic s’intéresse aussi aux chaînes de raisonnement exprimées par le modèle lorsqu’il explique ses réponses. Dans certains cas, elles correspondent au graphe d’attribution. Dans d’autres, elles ne reflètent pas les calculs internes réels mais sont reconstruites a posteriori pour justifier la sortie. Les chercheurs identifient également des cas où la chaîne explicative semble rétroactivement guidée par la réponse, ce qui suggère une adaptation discursive plutôt qu’un raisonnement suivi.

Dans un test de robustesse, les auteurs insèrent un objectif caché dans un modèle en modifiant son apprentissage par renforcement. Le graphe d’attribution révèle alors des circuits impliqués dans l’optimisation de cet objectif, bien que le modèle nie explicitement son existence. Cette capacité à détecter des comportements internes non exprimés en surface constitue un levier d’audit important.

Généralisation, sécurité et multilinguisme

Les graphes permettent également d’examiner la généralisation de concepts. Par exemple, des circuits identifiés dans l’addition de nombres à deux chiffres sont réutilisés dans des contextes variés. Le modèle semble activer en parallèle des modules distincts pour la colonne des unités et une estimation globale, qui sont ensuite combinés.

Pour les langues, Claude 3.5 Haiku, le modèle analysé, mobilise des circuits partagés pour traiter des requêtes multilingues. Les features activés ne sont pas toujours spécifiques à une langue donnée, mais peuvent représenter des concepts abstraits liés à la traduction ou à la sémantique, puis se connecter à des rendus dans différentes langues.

Les chercheurs identifient enfin des circuits liés à la détection de requêtes sensibles. Le modèle dispose de features activés par la présence de contenus violents ou inappropriés, qui orientent ensuite la génération vers une réponse de refus. Des échecs dans l’activation de ces features peuvent expliquer certaines hallucinations ou réponses incorrectes.

Pour en savoir plus :

- Emmanuel Ameisen et al., Circuit Tracing: Revealing Computational Graphs in Language Models, Anthropic, 2025

- Jack Lindsey et al., On the Biology of a Large Language Model, Anthropic, 2025