Près d'un quart des Américains déclarent qu’ils ont remplacé Google par un outil de recherche générative, généralement ChatGPT. Or, les chatbots ne redirigent pas vers les sites d'origine des informations, mais les reformulent directement dans leurs réponses en les citant en marge. Le Tow Center for Digital Journalism, un centre de recherche et développement affilié à l’université de Columbia à New York, a évalué huit outils d'IA pour mesurer leur capacité à retrouver et citer correctement les articles de presse. L'étude conclut à des performances globalement mauvaises, avec plus de 60 % de réponses incorrectes et une tendance générale à présenter ces erreurs avec une confiance injustifiée.

Une incapacité à refuser de répondre

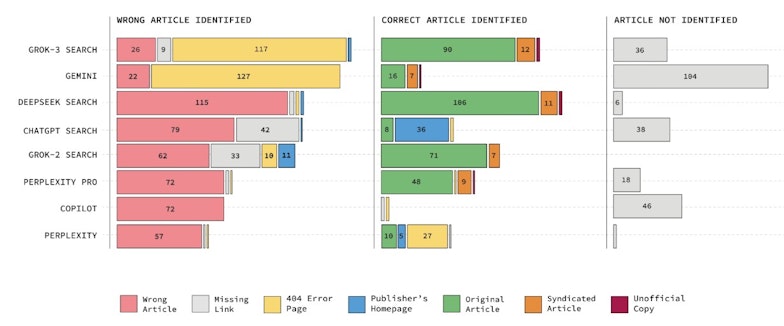

Les modèles testés ont généralement produit des réponses erronées plutôt que d'admettre leur incapacité à fournir une information fiable. ChatGPT, par exemple, a proposé 134 réponses incorrectes sur 200 tests, mais n'a exprimé un doute que dans 15 cas. Perplexity, un moteur conçu pour la recherche, s'est trompé dans 37 % des cas, tandis que Grok 3 a atteint un taux d'erreur de 94 %. Copilot a été le seul système à préférer refuser une réponse plutôt que de fournir une information incorrecte.

Les modèles premium, censés offrir de meilleures performances grâce à des ressources de calcul supérieures, ont paradoxalement présenté des taux d'erreur plus élevés que leurs versions gratuites. Perplexity Pro (20 dollars par mois) et Grok 3 (40 dollars par mois) ont répondu correctement à un plus grand nombre de questions que leurs homologues gratuits, mais avec un surcroît d'erreurs factuelles et une propension accrue à donner des réponses fausses avec assurance. Cette tendance accentue la difficulté pour l'utilisateur de distinguer le vrai du faux.

Certains moteurs ont accédé à du contenu alors même que les éditeurs avaient explicitement bloqué leurs robots d'exploration via le protocole Robots Exclusion. Perplexity Pro a correctement identifié près d'un tiers des articles issus de sites qui lui avaient interdit l'accès. Par exemple, la version gratuite de Perplexity a retrouvé et cité sans problème des articles payants de National Geographic, alors que le média a bloqué ses robots et ne dispose d'aucun accord avec le journal.

Des citations imprécises et des liens fictifs

Les outils analysés ne renvoient pas toujours vers les sources originales. Lorsqu'un article était correctement identifié, il était fréquemment cité via une version syndiquée sur Yahoo News ou AOL plutôt que via le site du média d'origine, même lorsque celui-ci avait un accord de licence avec l'IA. Perplexity Pro, par exemple, a cité des versions non officielles d'articles du Texas Tribune dans 30 % des cas.

Les différentes réactions des outils d'IA • Source : TCDJ

Les moteurs ont aussi tendance à inventer des URL. Plus de la moitié des réponses de Gemini et Grok 3 renvoyaient vers des liens erronés ou inexistants. Sur 200 tests effectués avec Grok 3, 154 citations menaient à des pages d'erreur. Ce phénomène, bien que plus rare chez d'autres modèles, constitue un frein à la vérification des sources.

Malgré des partenariats avec plusieurs groupes de presse, les performances des chatbots restent inégales. OpenAI et Perplexity, qui ont signé des accords avec le Guardian et Time, n'ont pas pour autant amélioré la précision de leurs citations de ces médias. Le San Francisco Chronicle, qui autorise l'accès à OpenAI, a vu son contenu correctement identifié par ChatGPT seulement une seule fois sur dix.

Pour en savoir plus :