Les modèles génératifs multimodaux représentent une avancée majeure dans la simulation du monde réel, avec des applications potentielles en réalité virtuelle, jeux vidéo, robotique et conduite autonome. Les initiatives de développement de world models (des modèles d'intelligence spatiales) se multiplient depuis l'année dernière, de Niantic – qui vient de céder Pokemon go et ses autres jeux pour se concentrer sur les world models – à World Labs, la start-up notamment fondée par Fei-Fei Li, de l’université Stanford, en passant par DeepMind.

Une approche dimensionnelle de la génération de contenu

Ces modèles doivent pouvoir comprendre et raisonner sur la structure et le fonctionnement du monde en trois dimensions, ce qui est essentiel pour des applications comme la réalité augmentée, la réalité virtuelle et la robotique. Cependant, la fragmentation des approches actuelles, qui traitent séparément les dimensions 2D, 3D et temporelles, limite la compréhension et la reproductibilité des mécanismes sous-jacents à ces simulations. Dans un article de synthèse, une équipe de chercheurs propose une unification des modèles de génération visuelle, analysant leur progression depuis les images 2D jusqu'à la modélisation dynamique en 4D.

L'étude décrit un cadre unifié qui classe les modèles selon les dimensions des données traitées. Elle débute par les modèles 2D, qui génèrent des images fixes en s'appuyant sur des architectures comme les réseaux antagonistes génératifs (GANs) et les modèles de diffusion. Ensuite, les auteurs passent aux modèles de vidéo, qui ajoutent la dimension temporelle pour modéliser le mouvement et la dynamique des scènes. Cette évolution mène à la génération 3D, qui intègre la représentation volumétrique des objets et des environnements.

La dernière étape de cette progression est la génération 4D, qui combine l'apparence, la géométrie et la dynamique dans une seule représentation unifiée. Cette approche permet de simuler des scènes évolutives et interactives, en réduisant l'écart entre les modèles statistiques et la complexité du monde réel.

Des avancées techniques et des défis à relever

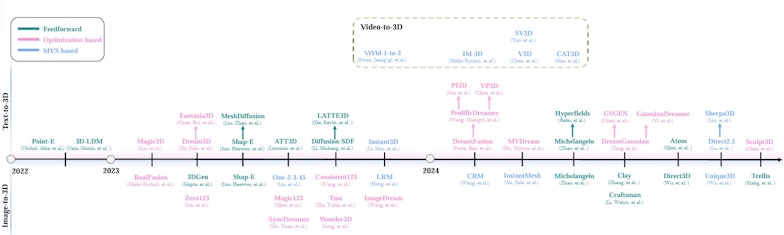

Aperçu chronologique des méthodes récentes de génération de texte en 3D, d'image en 3D et de vidéo en 3D • Source : Yuqi Hu et al.

L'analyse des modèles existants met en avant les forces et les limites de chaque paradigme. Les modèles 2D, bien qu'efficaces pour la synthèse d'images, peinent à garantir une cohérence spatiale et temporelle lorsqu'ils sont appliqués à la vidéo. De même, la génération 3D repose souvent sur des représentations explicites comme les maillages et les voxels, qui limitent la qualité des détails et la flexibilité du rendu.

L'un des principaux défis de la génération 4D est la complexité du calcul nécessaire pour modéliser la dynamique d'un environnement entier. Les auteurs soulignent que les modèles actuels sont souvent limités par des coûts computationnels élevés, rendant difficile leur application à grande échelle. En outre, l'évaluation de la qualité des modèles 4D reste un problème ouvert, faute de métriques standardisées pour mesurer la réalisme et la pertinence des simulations.

Pour contourner ces limitations, certaines approches récentes exploitent des réseaux neuronaux plus légers et des architectures hybrides combinant méthodes explicites et implicites. Les modèles basés sur la représentation gaussienne 3D ou les champs de rayonnement neuronal (NeRF) permettent d’améliorer la fidélité du rendu tout en réduisant la complexité calculatoire. Ces innovations visent à démocratiser l’usage des modèles 4D dans des environnements variés, notamment en simulation industrielle et en conception assistée par ordinateur.

Des applications multiples et des perspectives d'avenir

L'étude met en avant le potentiel des modèles multimodaux dans divers domaines. En réalité virtuelle, ils peuvent améliorer l'immersion en proposant des environnements plus réalistes et interactifs. Dans l'industrie du jeu vidéo, ces modèles pourraient permettre une génération automatique d'univers plus dynamiques et adaptatifs. Enfin, en robotique et en conduite autonome, une meilleure simulation du monde réel pourrait améliorer la prise de décision et l'adaptation aux environnements complexes.

Les auteurs identifient plusieurs pistes pour les recherches futures. Le développement de modèles plus efficaces en termes de calcul apparaît comme une priorité, notamment via des techniques de compression neuronale et d’apprentissage auto-supervisé. La création de nouvelles bases de données multimodales adaptées aux contraintes de la génération 4D constitue également un enjeu crucial. Enfin, la définition de métriques d'évaluation plus robustes et adaptées aux spécificités des contenus générés permettra de mieux juger la pertinence et la cohérence des simulations produites.

Ces avancées pourraient ouvrir la voie à une nouvelle génération de modèles capables de reproduire fidèlement la complexité du monde réel, avec des applications qui dépassent largement le cadre des technologies actuelles. L’unification des approches 2D, 3D et temporelles marque ainsi une étape essentielle vers des simulations plus réalistes et interactives, s’inscrivant dans une dynamique de progrès constant au sein de l’intelligence artificielle générative.

Pour en savoir plus :

- Yuqi Hu et al., Simulating the Real World: A Unified Survey of Multimodal Generative Models, Arxiv, 2025